OpenAIは2024年2月15日、テキストから最大60秒の動画生成AI「Sora」を発表しました。Soraは、大量の学習データと高度なアルゴリズムを用いて、テキスト指示に基づいた多様な動作やシーンを含む動画を生成するAIです。

この記事では、OpenAIの技術レポートを基に、Soraがいかにして動画を生成するのか、その仕組みをわかりやすく解説します。

- 動画生成AIに興味がある

- Soraの仕組みを簡単に知りたい

- Soraを使ってどんな動画が作れるのか知りたい

動画生成AI「Sora」の概要について知りたい方は、以下の記事を参照ください。

Soraなどの動画生成AIが動画を生成する仕組み

動画生成AI「Sora」は、テキスト、画像、あるいは動画のプロンプトを入力することで、新たな動画を生成できます。では、Soraをはじめとする動画生成AIは、どのようにして高度なタスクを実行できるのでしょうか。その秘密は、学習プロセスにあります。

プロンプトとは、動画生成AIに与える指示のことで、どのような動画を生成するかを具体的に伝えるものです。Soraはこの指示に基づいて、要求された動画を生成します。たとえば、「公園で花が咲く様子」というテキストプロンプトを入力すると、Soraはこの指示に基づいて、春の公園で花が開花する動画を生成します。画角、構図、色合い、質感など、詳細な指示でよりイメージに近い動画を作れます。

動画生成AIの学習プロセス

動画生成AIは、次の4つのステップを経て大量の画像や動画から学習し、プロンプトに基づいた動画を生成します。

- 画像や動画の分割

- パッチの抽出

- パッチのエンコード

- エンコードしたパッチの学習

各ステップについて、具体的な例を交えながら説明していきます。

1.画像や動画の分割

画像や動画を、小さなピースや区分(パッチ)に分割します。これは、一枚の大きな風景画をジグソーパズルのピースに分けるような作業です。

2.パッチの抽出

分割した各パッチから、色や形、質感など、重要な情報(特徴量)を抽出します。各ジグソーパズルのピースがどのような景色の一部なのかを理解するプロセスに似ています。

3.パッチのエンコード

抽出した特徴量を、機械学習モデルが処理しやすい形式に変換します。この変換をエンコードといいます。エンコードは、特徴量をAIが「読める」特別なコードに翻訳するようなイメージです。

4.エンコードしたパッチの学習

最後に、AIはこれらのパッチがどのように組み合わさり、相互に作用するかを学習します。これは、ジグソーパズルを完成させる際に、どのピースがどこに収まるかを学ぶプロセスと考えるとわかりやすいです。

このような学習プロセスを経て、動画生成AIは人物の動きや表情、背景の詳細、そして動画のコンテキスト(文脈)やストーリーを理解し、新たな動画を生成します。

動画生成AI Soraを構成する技術の仕組み

OpenAIの技術レポート「Video generation models as world simulators」では、動画生成AI「Sora」に関連する6つの技術が紹介されています。

- 動画や画像をパッチ化する

- 動画のサイズを圧縮する(動画圧縮ネットワーク)

- 圧縮した動画をさらに小さなパッチに分ける(時空潜在パッチ)

- 拡散モデルにトランスフォーマーを組み合わせる(拡散トランスフォーマー)

- 入力データをそのままの形で学習する

- 言語理解と再キャプション

専門的で理解が難しい部分もあるため、主要なポイントのみをわかりやすく解説していきます。

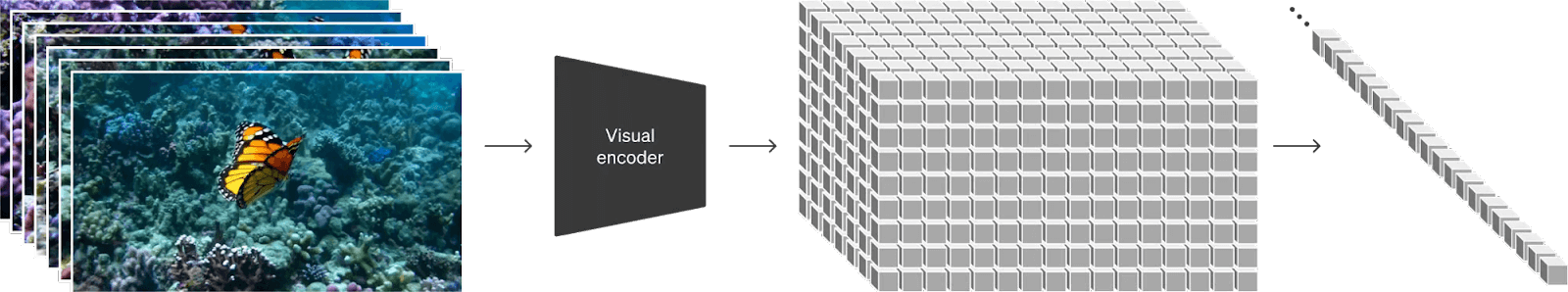

動画や画像をパッチ化する

Soraは、インターネットから収集した大量の画像や動画(=画像の連続体)を、「パッチ」と呼ばれる小さなタイルに分割してから学習を開始します。このプロセスを「パッチ化」といいます。

出典:OpenAI「Video generation models as world simulators」

Soraが大量の学習データをパッチ化するメリットは以下の3つです。

データ処理の効率化

大きな画像を小さな単位で扱うことで、全体を一度に処理しようとするよりも計算量を大幅に削減できます。たとえば、大きな部屋を掃除するとき、部屋のエリアを分けて少しづつ掃除する方が効率的です。Soraはパッチ化によって、画像を小さな部分まで効率よく処理できます。

複雑な視覚情報の学習

小さなパッチを分析することで、全体では見落としやすい細かな特徴やパターンを捉えられます。これは、パズルの一片をじっくり見ることで、それが全体のどの部分に当てはまるかを理解するようなものです。この方法により、Soraはより複雑な視覚情報を学ぶことができます。

データセットの拡張

一つの画像から複数のパッチを切り出すことで、学習用のデータ量を増やすことができます。これにより、Soraはより多様なデータを経験し、未知のデータに対しても予測精度を向上させることができます。

このように、パッチ化はSoraが視覚情報をより効率的かつ詳細に学習するために不可欠な技術です。

動画のサイズを圧縮する(動画圧縮ネットワーク)

動画はたくさんの連続する画像(フレーム)で構成されており、これら全てをそのまま扱うと非常にデータ量が多くなり、処理に時間がかかってしまいます。

そこでSoraは、「動画圧縮ネットワーク」という技術を使って、動画データを潜在空間と呼ばれる低次元空間(動画を小さなデータサイズで再現する空間)に圧縮します。

このプロセスは、自宅の部屋にある荷物を整理してまとめる作業に例えるとわかりやすいです。荷物の中から本当に必要なものだけを選び、それをクローゼット(潜在空間)に収納します。この潜在空間に収められた荷物は、部屋の荷物の「要約版」のようなものであり、本質的な情報は保持しながらも、大幅にデータサイズを小さくできます。この圧縮された形式のおかげで、動画を扱う際の処理効率が大幅にアップするのです。

動画をメールで送信する際に、ファイルサイズが大きすぎて送れないといった経験がある方も多いでしょう。ファイルサイズを圧縮すれば、より速く送ることができるのと同じ原理です。この技術によってSoraは動画生成プロセスを大幅に高速化できます。

圧縮した動画をさらに小さなパッチに分ける(時空潜在パッチ)

Soraは、潜在空間に圧縮した動画データを、「時空潜在パッチ」と呼ばれる小さな単位に分解します。

このプロセスは、大きな絵を描く際にキャンバスを小さなマス目に分け、それぞれのマス目を個別に描いていく方法に似ています。潜在空間に圧縮された動画データは元の動画の「エッセンス」を凝縮したものであり、Soraはこのエッセンスをさらに詳細な「時空潜在パッチ」に分割します。

時空潜在パッチは、動画が時間とともにどのように変化していくか(時間軸に沿った変化)、そして画面内で物体がどのように配置されているか(空間軸に沿った配置)を表しているため、動画の動きと構造を精密に捉えることができます。

これにより、Soraは動画内の微細な変化を詳細に理解することができ、「公園で風に揺れる木々の葉の動き」や「感情の変化に応じて変わる表情」など、時間と空間を超えた動画の複雑な特性を把握します。

従来の動画生成AIと比較して、Soraがより自然でリアルな動画を作り出せる理由は、この革新的なステップにあります。この技術により、動画生成の精度と自由度が大きく向上しているのです。

拡散モデルにトランスフォーマーを組み合わせる(拡散トランスフォーマー)

Soraは、テキストから高品質な動画を生成するために、「拡散モデル」と「トランスフォーマー」という二つの技術を組み合わせた「拡散トランスフォーマー」という技術を採用しています。

出典:OpenAI「Video generation models as world simulators」

まず、「拡散モデル」というのは、画像や動画などのデータを生成する方法の一つです。最初に完全なランダムなノイズ(意味のない乱雑なデータ)からスタートして、少しずつこのノイズを取り除いていくことで、徐々に目的の画像や動画などのデータを形成していきます。

次に「トランスフォーマー」とは、テキストや画像の情報を処理するための技術であり、人間の脳の仕組みを模倣しています。この技術は文章理解や画像生成において高い能力を発揮します。

Soraはこの二つの技術を組み合わせています。つまり、ランダムなノイズから始めて、そのノイズを少しずつ取り除く「拡散モデル」のプロセスに、テキストや画像を深く理解し処理する「トランスフォーマー」の能力を加えるわけです。

これにより、Soraはただのテキストから(たとえば「公園で遊ぶ犬」のような説明から)、それに合った動画を直接生成できるようになります。

入力データをそのままの形で学習する

従来の動画生成AIは、入力データを特定のサイズに標準化する必要がありました。しかし、Soraはさまざまな解像度やアスペクト比を持つ動画を、そのままの形(ネイティブアスペクト比)で学習できます。

この柔軟性により、生成される動画の構図とフレーミング(被写体をどう写真に写しこむか、どう切り取るかを考えること)の質が向上しました。

出典:OpenAI「Video generation models as world simulators」

左が正方形にトリミングして学習した動画、右がネイティブアスペクト比で学習した動画です。

さらにSoraは、スマホ、タブレット、PCなど、さまざまなデバイスに最適化されたコンテンツを直接生成できます。また、低解像度の画像や動画を生成することで、時間とコストを節約しながらアイデアの検証が可能です。

言語理解と再キャプション

OpenAIは、画像生成AI「DALL-E 3」で話題となった再キャプション技術を、動画生成AI「Sora」にも応用しています。

DALL-E 3は、OpenAIが開発したテキストから画像を生成するAIです。DALL-E 3には、画像の説明文(キャプション)を改善して、より詳細な説明文を生成する再キャプション技術が搭載されています。

たとえば、ある画像の説明文が「犬が座っている」だけだった場合、DALL-E 3の再キャプション技術は、「金色の毛並みをしたゴールデンレトリバーが、夕日の光が差し込む公園の滑り台の近くで、しっぽを振って座っている」というような、より具体的な説明文を生成することができます。

この技術をSoraに応用することで、プロンプトにより忠実で、かつ詳細でリアルな動画を生成できるようになります。

動画生成AI「Sora」の安全かつ倫理的な展開に向けたOpenAIの取り組み

革新的な学習メカニズムで注目を集める動画生成AI「Sora」ですが、同時に克服すべき課題も存在します。OpenAIはリスクを軽減するために、以下の対策を講じています。

- 悪意ある利用を防ぐためのフィルタリング機能の強化

- 生成された動画の真偽を検証する技術の開発

- Soraの利用規約を策定

- C2PAメタデータ(出所や関連情報の検証機能)の付与

OpenAIのCTO、ミラ・ムラティ氏は、ウォール・ストリート・ジャーナルとのインタビューで、Soraを2024年後半にリリースする計画を発表しました。これらの課題が解決され、Soraが安全かつ倫理的に展開される日は近いかもしれません。

参考:The Wall Street Journal「OpenAI Made AI Videos for Us. These Clips Are Good Enough to Frea¥k Us Out.」

高品質な動画を効率的に | VIDWEBの生成AIを活用した動画制作サービス

Soraを始めとした動画生成AIには、高度な動画生成能力がありますが、複雑なシーンや詳細な因果関係を再現するには限界があります。企業の広告やプロモーション動画など、信頼性が求められる内容では、正確さや安全性、著作権の問題など細かいチェックと人の手による編集が欠かせません。

VIDWEBは、Soraを含む最新の動画生成AI技術を駆使して、従来の方法よりもコストを抑えて高品質な動画を提供できる制作会社です。

商品説明、企業紹介、マニュアル、イベント紹介、採用活動、研修プログラム、営業支援ツール、投資家情報(IR)、広報用動画など、お客さまのニーズに合わせた動画制作サービスを高品質かつ低コストで提供します。

アイデアを動画に変換 | 動画生成AI「Sora」の仕組みを理解してビジネスを加速

OpenAIの「Sora」をはじめとする動画生成AI技術は、コスト削減、パーソナライゼーション、創造性の向上、リアルタイムマーケティングなど、企業のマーケティング戦略に大きな変革をもたらす可能性を秘めています。

ただし、現時点では情報の正確性や安全性、著作権侵害のリスクといった課題も存在します。これらの課題を解決し、AI技術の潜在力を完全に引き出すためには、動画生成AIの専門知識を持つ制作会社のサポートが不可欠です。

VIDWEBは、最新の動画生成AI技術を駆使し、従来の方法に比べてコストパフォーマンスに優れた高品質な動画制作サービスを提供します。幅広いサービスラインナップで動画マーケティングをサポートいたします。お気軽にお声掛けください!

動画制作の無料相談

動画制作の無料相談

無料資料ダウンロード

無料資料ダウンロード